Nhịp AI – Bản tin tuần 52

AI đang bước vào nhà máy, và nhà máy thì phải có đồng hồ đo, sổ nhật ký, và cửa an toàn.

📰 Tuần 52 (22/12/2025 - 28/12/2025)

Tuần này có một mạch chuyện khá rõ, AI đang chuyển từ “mô hình trả lời” sang “tác tử biết làm việc”, và khi AI biết làm việc, câu hỏi lớn nhất không còn là “thông minh đến đâu?”, mà là “kiểm soát, đo lường, và chịu trách nhiệm thế nào?”

Điểm tin nổi bật trong tuần

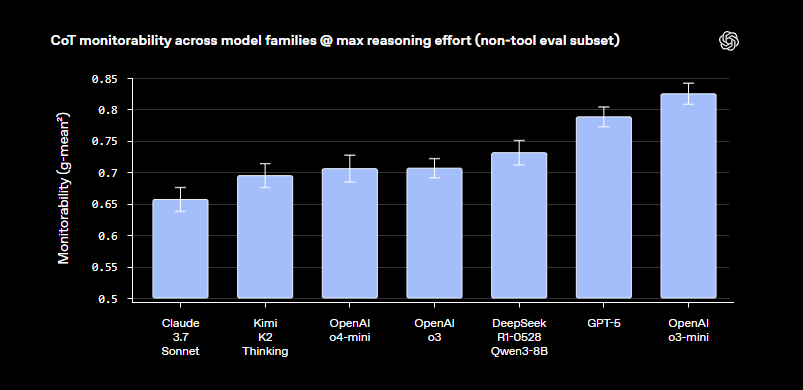

Một là, OpenAI đưa ra nghiên cứu đo “khả năng giám sát suy nghĩ”, tức khả năng để một hệ thống giám sát đọc chuỗi lập luận (chain of thought) và phát hiện ý đồ xấu tốt hơn so với chỉ nhìn đầu ra. (OpenAI)

Hai là, ChatGPT bước thêm một nấc “Everything App”, OpenAI mở App Directory, Apps SDK, để dịch vụ bên thứ ba chạy “ngay trong ChatGPT”, vẫn giữ cơ chế xác nhận của người dùng cho các hành động ghi dữ liệu. . (Reddit)

Ba là, câu chuyện “tác tử đi web” gặp bức tường bảo mật, OpenAI nói prompt injection có thể không bao giờ được “giải quyết dứt điểm”, và NCSC của Anh cũng cảnh báo tương tự, đây là vấn đề bản chất giữa dữ liệu và chỉ dẫn trong mô hình ngôn ngữ. . (OpenAI)

Bốn là, cuộc đua hạ tầng và suy luận (inference) nóng lên, Groq công bố thỏa thuận cấp phép công nghệ suy luận không độc quyền với Nvidia, kèm dịch chuyển nhân sự cấp cao, tạo thêm một lớp “đinh” cho tương lai inference. (The Register)

Năm là, phía “open source” tiếp tục tăng lực, MiniMax công bố M2.1, và GLM 4.7 được cộng đồng đẩy mạnh như một lựa chọn coding mạnh. (Hugging Face)

Sáu là, “đo lường hành vi” lên ngôi, Anthropic mở Bloom, một khung đánh giá hành vi có khả năng sinh tình huống mới nhưng giữ nguyên định nghĩa hành vi, chống “học tủ từ benchmark”. (arXiv)

Bảy là, câu chuyện “bộ nhớ của tác tử” được hệ thống hóa trong một survey dài, nhấn mạnh forms, functions, dynamics thay vì gọi chung chung short term, long term. (arXiv)

Tám là, tâm trạng của giới lập trình viên được “đóng dấu” bằng câu than của Karpathy, cảm giác bị bỏ lại phía sau không phải vì gõ chậm, mà vì tầng trừu tượng mới, agents, tools, memory, permissions. (X.com)

Phân tích những tin chính

1) Giám sát suy nghĩ, khả năng kiểm soát mới của thời đại tác tử

Điểm giá trị của nghiên cứu OpenAI không nằm ở câu “xem chain of thought để an toàn hơn”, mà nằm ở việc họ cố đo lường được “monitorability” như một biến kỹ thuật, và thấy nó tăng khi chuỗi lập luận dài hơn, đồng thời có thể phải trả “thuế suy luận” (monitorability tax), tức tăng test time compute để đổi lấy dấu vết dễ giám sát hơn. (OpenAI)

Hàm ý thực dụng với doanh nghiệp là, một là, khi triển khai tác tử cho quy trình nhạy cảm, bạn cần “chế độ minh bạch”, tăng effort suy luận, tăng log, tăng câu hỏi follow up để lộ tín hiệu, hai là, bạn phải coi đây là trade off chi phí vận hành chứ không phải khẩu hiệu đạo đức. (OpenAI)

2) App Directory và Apps SDK, ChatGPT đi vào pha hệ sinh thái

OpenAI đang biến ChatGPT thành lớp giao diện điều phối dịch vụ, nơi app nằm trong hội thoại, gọi bằng mention, hoặc chọn trực tiếp trong UI, và vẫn yêu cầu người dùng xác nhận trước khi thực thi hành động bên ngoài. Điều quan trọng nhất với doanh nghiệp không phải “có thêm app”, mà là mô hình quản trị, RBAC, audit log, kiểm soát hành động ghi dữ liệu. (Reddit)

Nếu tuần này bạn đang nghĩ về “AI agents”, thì đây là tín hiệu rõ, tác tử sắp đi thẳng vào hệ thống nghiệp vụ, và câu hỏi an toàn thông tin sẽ trở thành điều kiện gia nhập, không còn là phần phụ. (Reddit)

3) Prompt injection, bài toán không có “viên đạn bạc”

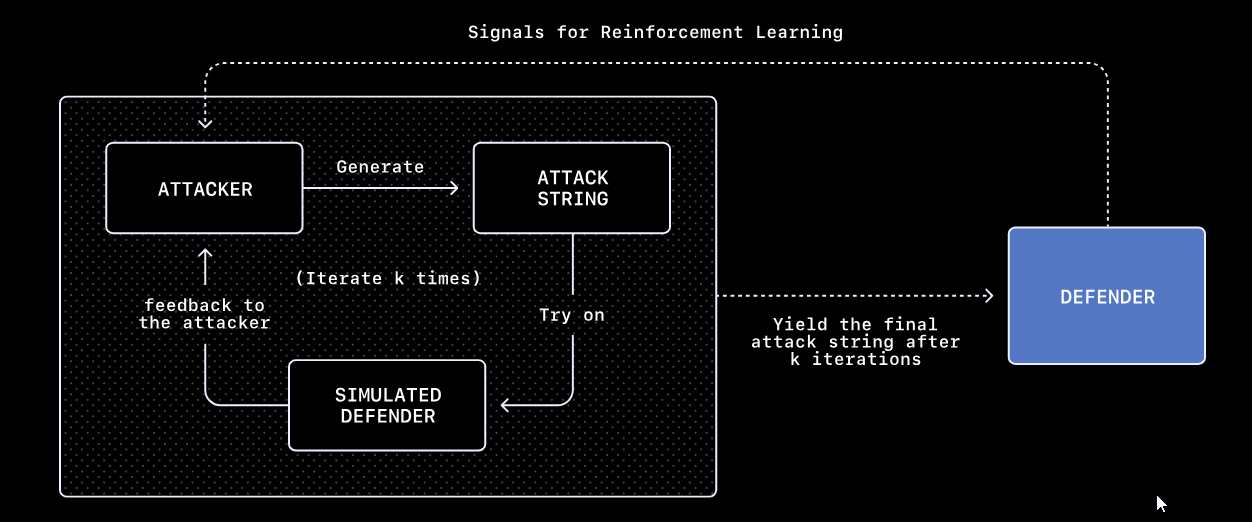

OpenAI nói prompt injection giống social engineering, khó có một lời giải tuyệt đối, và họ xây hệ thống red teaming tự động để tìm khai thác nhanh hơn. (OpenAI)

NCSC của Anh đi xa hơn ở mặt nguyên lý, vì LLM không có ranh giới cứng instruction versus data, nên không thể “vá một lần là xong” kiểu parameterized query như SQL injection, hướng đúng là defense in depth, giới hạn công cụ, giới hạn quyền, chặn side effects bằng kiểm tra quyết định, và giám sát chuỗi gọi công cụ. (Abseil)

Nếu bạn đang xây trợ lý duyệt web, đọc email, làm procurement, hoặc tự điền biểu mẫu, thì tuần này là một cảnh báo thẳng, không có đường tắt.

4) Nvidia và Groq, câu chuyện inference là chi phí vận hành của mọi sản phẩm AI

Groq thông báo thỏa thuận cấp phép công nghệ suy luận không độc quyền với Nvidia, kèm việc một số lãnh đạo chuyển sang Nvidia, trong khi Groq vẫn hoạt động độc lập. (Groq)

Đọc động thái này theo kiểu chiến lược là, Nvidia không chỉ muốn nhanh hơn, mà muốn giữ quyền định hình “AI factory stack” của thời inference, nơi chi phí mỗi token trở thành chỉ số sống còn với sản phẩm.

5) Bloom và “đo lường hành vi”, từ benchmark sang đánh giá có sức sống

Bloom của Anthropic chọn hướng “khóa hành vi, không khóa tình huống”, tức giữ định nghĩa hành vi, liên tục sinh tình huống mới, chống việc benchmark bị lộ vào dữ liệu huấn luyện. Đây là một bước rất đáng chú ý, vì trong kỷ nguyên tác tử, chúng ta cần đo “hành vi trong hoàn cảnh biến đổi” hơn là đo điểm số trên một bộ câu hỏi. (Anthropic)

6) “Brain rot”, dữ liệu rác làm suy nghĩ kém đi

Paper về “brain rot” cho thấy continued training trên nội dung mạng xã hội chất lượng thấp có thể làm giảm năng lực lập luận, dùng ngữ cảnh dài, và cả chỉ số an toàn, hiệu ứng khó phục hồi hoàn toàn. (arXiv)

Đây là lời nhắc cho bất kỳ ai đang “tự nấu dữ liệu”, lọc dữ liệu không còn là việc tối ưu, nó là an toàn vận hành.

Một số tin về AI trong tuần ở Việt Nam

Một là, Chính phủ và Bộ Khoa học và Công nghệ có các thông tin điều hành liên quan nhiệm vụ khoa học công nghệ và chuyển đổi số, trong đó AI tiếp tục là một mũi nhọn trong các ưu tiên triển khai. (Ministry of Science and Technology)

Hai là, các hoạt động hệ sinh thái ở địa phương, như Đà Nẵng gắn AI với bài toán thành phố thông minh và đổi mới sáng tạo, tiếp tục được truyền thông chính thống ghi nhận. (VietNamNet News)

Ba là, nhiều tin dạng “nền” về số liệu, chuẩn hóa, và hạ tầng dữ liệu xuất hiện dày hơn, đây là dấu hiệu Việt Nam bắt đầu bước vào pha làm thật, tức lo dữ liệu, đo lường, tiêu chuẩn, thay vì chỉ nói về công cụ. (VnEconomy)

Hàm ý với Việt Nam

Một là, chuyển trọng tâm đào tạo từ “dùng tool” sang “governance và kiểm soát”, cụ thể là quản trị tác tử, phân quyền, nhật ký hành động, quy trình xác nhận, và red teaming cho prompt injection.

Hai là, xây năng lực “đánh giá hành vi” (behavioral evaluation), không đợi luật hay quy chuẩn hoàn hảo rồi mới làm, Bloom cho thấy bạn có thể bắt đầu bằng việc định nghĩa hành vi cần tránh, sinh tình huống, chấm điểm, theo dõi drift.

Ba là, coi hạ tầng inference là chiến trường cạnh tranh quốc gia và doanh nghiệp, vì chi phí vận hành AI không nằm ở demo, nó nằm ở hàng triệu lượt suy luận mỗi ngày, và các động thái kiểu Nvidia, Groq cho thấy ai chiếm được cost curve sẽ chiếm được thị trường.

Bốn là, dữ liệu là “đạo đức bằng kỹ thuật”, nếu dữ liệu nhiễu, mô hình sẽ suy nghĩ kém đi, và doanh nghiệp Việt Nam cần chuẩn hóa pipeline dữ liệu trước khi mơ về tác tử tự động.

Năm là, tâm thế nhân lực, câu của Karpathy là lời nhắc, lợi thế mới đến từ khả năng tổ chức hệ thống làm việc với AI, không phải từ tốc độ gõ phím.

Kết luận

Tuần 52 là một tuần “định hình cấu trúc”, OpenAI nói về giám sát suy nghĩ, Anthropic nói về đo lường hành vi, NCSC nói về prompt injection không thể hết hẳn, OpenAI mở App Directory để tác tử đi vào dịch vụ, Nvidia khóa chặt câu chuyện inference. Nói như người La Mã, đây là lúc chuyển từ lời hứa sang kỷ luật, từ hùng biện sang cơ chế, từ cảm hứng sang vận hành.

Nếu cần một câu chốt, AI đang bước vào nhà máy, và nhà máy thì phải có đồng hồ đo, sổ nhật ký, và cửa an toàn.

Bản tin này cũng khép lại một năm đầy sôi động của lĩnh vực trí tuệ nhân tạo (AI) và mở ra một không gian mới và đầy đột phá của AI trong năm 2026.

Nhịp AI | Bản tin tuần – Tổng hợp, chọn lọc và phân tích các chuyển động quan trọng của AI, dành cho người làm chiến lược, công nghệ và chính sách.