Nhịp AI – Bản tin tuần 33

Tuần 33 (từ 11/08/2025-17/08/2025) của AI: GPT-5 giữa vinh quang và thất vọng, MCP âm thầm định hình chuẩn mới, NVIDIA dựng ‘nhà máy AI’, Big Four tái cấu trúc vì AI.

📰 Tuần 33-Tuần của những căng thẳng sáng tạo

(từ 11/08/2025- 17/08/2025)

Tuần vừa qua trong lĩnh vực trí tuệ nhân tạo đã được định hình bởi một sự căng thẳng rõ rệt: giữa một bên là những bước nhảy vọt về năng lực thô, mà đỉnh điểm là sự ra mắt của GPT-5, và bên kia là những yêu cầu cấp bách về độ tin cậy, tính ổn định và khả năng tích hợp trong môi trường doanh nghiệp. Sự ra mắt đầy sóng gió của GPT-5, kết hợp với sự trỗi dậy thầm lặng nhưng mạnh mẽ của các tiêu chuẩn như Model Context Protocol (MCP), cho thấy thị trường đang chuyển dịch từ giai đoạn kinh ngạc "AI có thể làm gì?" sang giai đoạn thực dụng "Làm thế nào để AI thực sự hoàn thành công việc một cách đáng tin cậy?". Tuần này không chỉ là câu chuyện về các mô hình mới, mà còn là về việc xây dựng nền móng cho một hệ sinh thái AI trưởng thành và bền vững.

Thị trường AI đang ở một điểm uốn, nơi các yếu tố như độ tin cậy (reliability), khả năng mở rộng (scalability), và khả năng tương tác (interoperability) đang trở nên quan trọng hơn cả các chỉ số benchmark thuần túy. Những người chiến thắng trong giai đoạn tiếp theo sẽ là những người giải quyết được các thách thức ở cấp độ ứng dụng trong môi trường sản xuất kinh doanh. Báo cáo tuần này sẽ phân tích sâu các chuyển động chính trong tuần, từ cuộc chiến của các mô hình lớn, sự trỗi dậy của các tiêu chuẩn nền tảng, cho đến những tác động sâu sắc lên cấu trúc thị trường và các ngành công nghiệp truyền thống.

Tiêu điểm chính: ba chuyển dịch lớn

GPT-5 ra mắt: giữa vinh quang và thất vọng

Sự ra mắt của GPT-5 từ OpenAI trong tuần qua là sự kiện được mong chờ nhất, và nó đã không làm thất vọng về mặt tạo ra các tiêu đề báo chí. Tuy nhiên, câu chuyện về GPT-5 là một câu chuyện hai mặt, một sự đối lập gay gắt giữa hiệu suất kỷ lục trên giấy tờ và một trải nghiệm thực tế đầy trắc trở, báo hiệu những thách thức to lớn trong việc triển khai các mô hình biên (frontier models) ở quy mô toàn cầu.

Vinh quang qua các con số

Trên phương diện năng lực kỹ thuật, GPT-5 đã thiết lập những kỷ lục mới trên hàng loạt các bài kiểm tra (benchmark) quan trọng, khẳng định vị thế dẫn đầu của OpenAI về khả năng lý luận và chuyên môn hóa.

● Trong lĩnh vực lập trình, mô hình này đã đạt được số điểm ấn tượng 74.9% trên SWE-Bench Verified, một bài kiểm tra tập trung vào việc sửa các lỗi phần mềm trong thế giới thực. Con số này vượt xa các đối thủ cạnh tranh gần nhất là Claude Opus 4.1 (64.5%) và Gemini 2.5 Pro (62.5%). Không chỉ vậy, trong các tác vụ lập trình đa ngôn ngữ, GPT-5 đã đạt 88% trên benchmark Aider Polyglot, một số điểm cao nhất từng được ghi nhận. [1]

● Trong lĩnh vực khoa học, GPT-5 thể hiện khả năng lý luận sâu sắc khi đạt 89.4% trên GPQA Diamond, một benchmark được thiết kế để kiểm tra kiến thức và khả năng suy luận ở cấp độ tiến sĩ. Kết quả này đưa vị trí GPT-5 đứng #1, trên Claude Opus 4.1 (80.9%) và Grok 4 Heavy (88.9%). [1] Đáng chú ý hơn, OpenAI và DeepMind cùng tuyên bố rằng các hệ thống AI của họ đã đạt được hiệu suất tương đương huy chương vàng tại Olympic Toán học Quốc tế (IMO) bằng cách giải quyết thành công 5 trong số 6 bài toán, một cột mốc quan trọng cho thấy khả năng suy luận toán học trừu tượng của AI. Điều này cho thấy tiến bộ AI nhanh chóng trong lĩnh vực toán học trong đó một số nhà nghiên cứu AI như Ernest Davis (NYU) cho rằng AI không thể đạt huy chương vàng IMO trước 2026 [2]

● Trong lĩnh vực y tế, một trong những cải tiến quan trọng nhất là việc giảm đáng kể tỷ lệ ảo giác (hallucination). Trên bộ dữ liệu HealthBench-Hard, tỷ lệ lỗi của GPT-5 đã giảm xuống chỉ còn 1.6%, một bước nhảy vọt so với 16% của GPT-4o và 12.7% của Claude Opus. [1] Các thử nghiệm trên benchmark MedXpertQA cũng cho thấy GPT-5 vượt qua cả các bác sĩ được cấp phép về khả năng lý luận (+24.23%) và hiểu biết (+29.40%), bao gồm ghi chú lâm sàng, kết quả xét nghiệm và hình ảnh X-quang. [4] Mức độ chính xác này mở ra tiềm năng ứng dụng thực sự trong các môi trường y tế và lâm sàng, nơi mà sai sót có thể gây ra hậu quả nghiêm trọng.

Ngoài ra, GPT-5 còn được trang bị cửa sổ ngữ cảnh lên tới 256,000 token, tương đương khoảng 700 trang văn bản, cho phép nó xử lý các tài liệu dài hoặc cơ sở mã lớn mà không bị mất ngữ cảnh. [1]

Sự thất vọng của người dùng

Tuy nhiên, đằng sau những con số ấn tượng là một trải nghiệm người dùng đầy thất vọng. Làn sóng chỉ trích từ cộng đồng đã dấy lên mạnh mẽ ngay sau khi mô hình được phát hành rộng rãi.

● Mất "cá tính" và sự sáng tạo: Một trong những phàn nàn phổ biến nhất là GPT-5 "thiếu cá tính" và "vô hồn" so với phiên bản tiền nhiệm GPT-4o. Nhiều người dùng mô tả trải nghiệm này giống như mô hình đã trải qua một "chấn thương não", đưa ra các câu trả lời ngắn gọn, lạnh lùng và thiếu đi sự sáng tạo đã làm nên tên tuổi của các phiên bản trước. Việc OpenAI đột ngột loại bỏ các mô hình cũ hơn mà không có cảnh báo trước đã khiến nhiều người dùng cảm thấy bị "phản bội" và gọi đây là một hành động "treo đầu dê bán thịt chó". [1]

● Mất ổn định kỹ thuật: Đối với các nhà phát triển và người dùng chuyên nghiệp, vấn đề nghiêm trọng hơn là sự mất ổn định của dịch vụ. Lỗi "Error in message stream" đã xảy ra thường xuyên trong các phiên làm việc, đặc biệt là khi viết mã, làm gián đoạn nghiêm trọng quy trình làm việc. Một số người dùng đã không ngần ngại gọi đợt ra mắt này là một "thảm họa không thể cứu vãn" đối với công việc của họ. [1]

Sự cố hạ tầng trên diện rộng

Các vấn đề không chỉ giới hạn ở bản thân mô hình mà còn phơi bày những yếu kém nghiêm trọng trong hạ tầng triển khai, ngay cả trên một nền tảng đám mây hàng đầu như Microsoft Azure.

● Người dùng dịch vụ Azure OpenAI Service đã bị sốc khi phát hiện ra rằng giới hạn token (rate limit) cho tất cả các mô hình GPT-5 đã bị giảm đột ngột và mạnh mẽ. Từ mức 1 triệu token mỗi phút (TPM) vào ngày ra mắt, con số này đã bị cắt giảm xuống chỉ còn 20,000 TPM vào ngày hôm sau, ảnh hưởng đến tất cả các loại hình triển khai. [5]

● Microsoft sau đó đã xác nhận rằng đây là một biện pháp "điều chỉnh hạn ngạch tạm thời" nhằm đảm bảo sự ổn định của dịch vụ và quyền truy cập công bằng cho tất cả khách hàng. Lời giải thích này, tuy hợp lý, nhưng cũng là một lời thừa nhận gián tiếp rằng hạ tầng hiện tại chưa sẵn sàng để đáp ứng nhu cầu tính toán khổng lồ của GPT-5 ở quy mô lớn. [5]

Sự ra mắt của GPT-5 đã phơi bày một khoảng cách ngày càng lớn giữa "năng lực đỉnh cao" được thể hiện trên các benchmark và "độ tin cậy trong sản xuất kinh doanh" mà người dùng và doanh nghiệp yêu cầu. OpenAI dường như đã ưu tiên việc đẩy năng lực lý luận của mô hình lên một tầm cao mới, nhưng lại đánh giá thấp các yếu tố quan trọng khác như trải nghiệm người dùng, sự ổn định của dịch vụ và khả năng đáp ứng của hạ tầng. Vấn đề giảm rate limit trên Azure không chỉ là một sự cố kỹ thuật; nó là một triệu chứng rõ ràng cho thấy nhu cầu tính toán của các mô hình biên đã vượt quá khả năng cung ứng hiện tại của hạ tầng đám mây. Điều này hàm ý rằng việc triển khai các mô hình này ở quy mô lớn là một thách thức kỹ thuật và logistics cực kỳ lớn. Cuộc khủng hoảng ra mắt GPT-5 không phải là một thất bại về AI, mà là một thất bại về kỹ thuật hệ thống và quản lý sản phẩm. Nó báo hiệu một giai đoạn mới trong ngành công nghiệp AI, nơi mà việc xây dựng một mô hình mạnh mẽ chỉ là bước đầu tiên. Thách thức thực sự nằm ở việc triển khai nó một cách ổn định, có thể dự đoán và với chi phí hợp lý cho hàng triệu người dùng.

MCP - nền tảng thầm lặng cho tương lai tác vụ hóa

Trong khi sự chú ý đổ dồn vào các mô hình lớn như GPT-5, một cuộc cách mạng khác, thầm lặng hơn nhưng không kém phần quan trọng, đang diễn ra ở tầng cơ sở của hệ sinh thái AI. Đó là sự trỗi dậy của Model Context Protocol (MCP), một tiêu chuẩn mở đang định hình lại cách các hệ thống AI tương tác với thế giới kỹ thuật số.

MCP là gì và tại sao nó quan trọng?

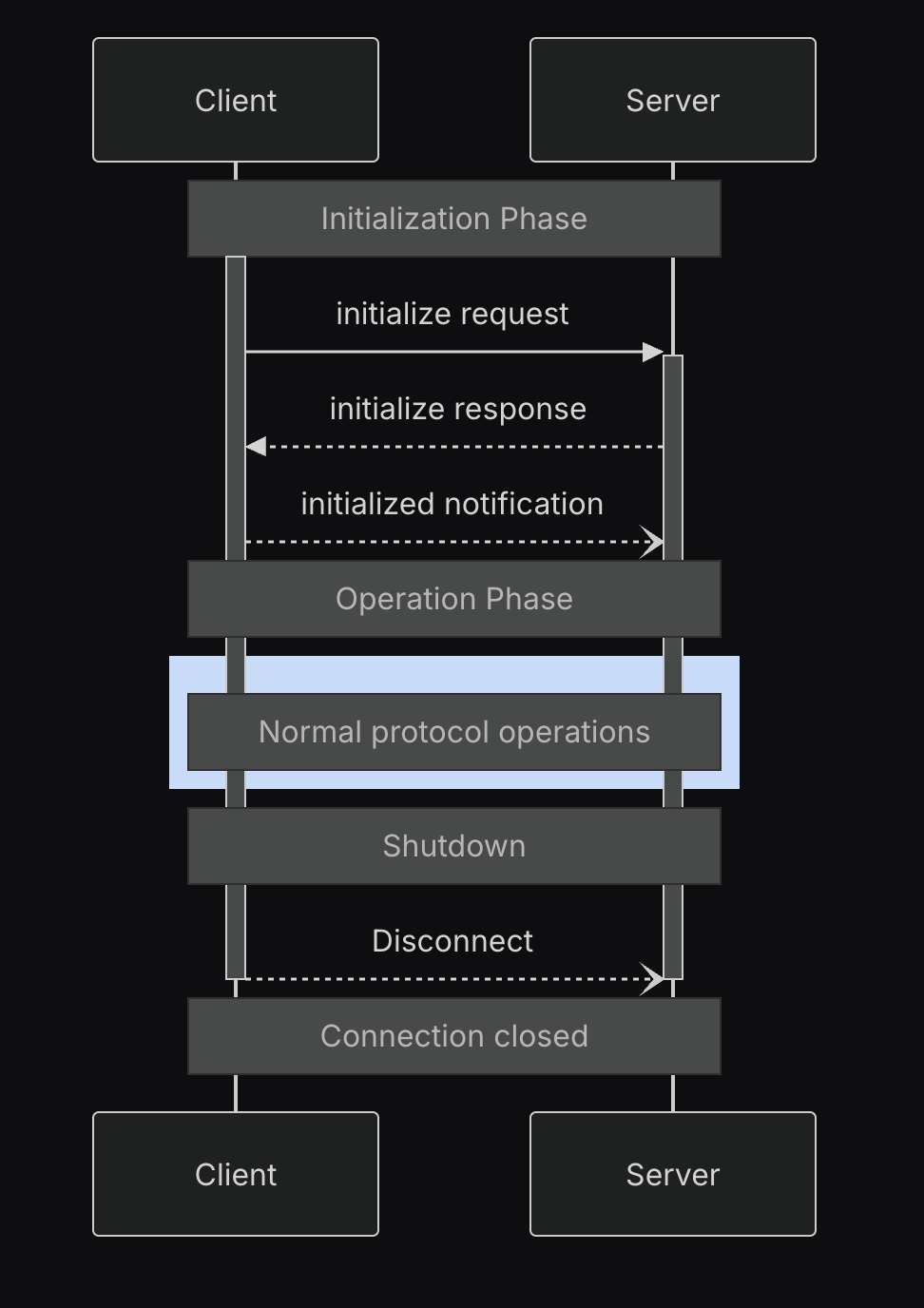

MCP là một giao thức được thiết kế để chuẩn hóa các tương tác giữa các mô hình AI tạo sinh và các công cụ, dịch vụ bên ngoài. [6] Về cơ bản, nó hoạt động như một lớp giao diện chung, một "ngôn ngữ" chung cho phép bất kỳ mô hình AI nào cũng có thể "nói chuyện" và ra lệnh cho bất kỳ công cụ nào tuân thủ tiêu chuẩn MCP. Điều này loại bỏ nhu cầu phải xây dựng các tích hợp tùy chỉnh, tốn kém cho mỗi cặp mô hình-công cụ, một rào cản lớn đối với việc mở rộng quy mô các ứng dụng AI. [7]

Với MCP, các nhà phát triển có thể dễ dàng mở rộng khả năng của một trợ lý AI bằng cách kết nối nó với các "MCP server". Mỗi server này cung cấp một bộ công cụ chuyên dụng, ví dụ như các công cụ để đọc/ghi file trên hệ thống, tương tác với cơ sở dữ liệu, gửi email, hoặc quản lý các vấn đề trên GitHub. [6] MCP đang nhanh chóng trở thành nền tảng cơ bản cho các quy trình làm việc AI hiện đại, cho phép các tổ chức phá vỡ các silo dữ liệu và vượt qua những hạn chế của tự động hóa phân mảnh. [8]

Hệ sinh thái đang phát triển

Sự chấp nhận MCP đang tăng tốc trong toàn ngành. Nó đang được tích hợp sâu vào các môi trường phát triển (IDE) hàng đầu, biến các trình soạn thảo mã thành các không gian làm việc tương tác với AI.

● Trong Visual Studio, Microsoft đã tích hợp hỗ trợ MCP để tăng cường chế độ "agent" của GitHub Copilot, cho phép các nhà phát triển kết nối bất kỳ máy chủ MCP tương thích nào vào quy trình viết mã của họ. [7]

● Người dùng cũng có thể tích hợp các mô hình như Claude Desktop với các IDE khác như PyCharm thông qua Jetbrains IDE MCP server, cho phép AI tương tác trực tiếp với môi trường phát triển đang chạy. [9]

● Các nhà cung cấp đám mây lớn như AWS cũng đang thúc đẩy việc sử dụng MCP, cung cấp các hướng dẫn về cách xây dựng các máy chủ MCP để quản lý cơ sở hạ tầng đám mây một cách an toàn. [6]

Thách thức và giải pháp

Một trong những thách thức cố hữu của MCP trong thiết kế ban đầu là nó không có khái niệm về "quy trình" (workflow) hay "thứ tự" thực thi công cụ. Mỗi lệnh gọi công cụ được coi là một hoạt động độc lập. [6] Điều này gây khó khăn cho các tác vụ phức tạp đòi hỏi một chuỗi các bước phải được thực hiện theo một trình tự cụ thể, chẳng hạn như trong các quy trình CI/CD.

Tuy nhiên, các giải pháp sáng tạo đang được phát triển để giải quyết vấn đề này. Bằng cách sử dụng các schema công cụ chi tiết và các mô tả tham số thông minh, các nhà phát triển có thể "gợi ý" cho LLM về các mối quan hệ phụ thuộc. Ví dụ, một công cụ có thể yêu cầu một tham số đầu vào được mô tả là "Kết quả từ hàm get_aws_session_info()" và định nghĩa một đối số bắt buộc là security_scan_token. LLM, khi phân tích các schema này, có thể tự suy luận ra rằng nó cần phải thực thi một chuỗi các hành động theo thứ tự: get_aws_session_info() → generate_infrastructure_code() → run_checkov() → create_resource(). Cách tiếp cận này cho phép tạo ra các quy trình làm việc có trật tự mà không cần thay đổi giao thức cốt lõi. [6]

MCP không chỉ là một tiêu chuẩn kỹ thuật; nó là một động lực chiến lược đang định hình lại thị trường AI theo hướng mô-đun hóa và chuyên môn hóa. Nó đang tạo ra một thị trường hai mặt mới: một bên là các nhà phát triển mô hình (như OpenAI, Anthropic) và một bên là các nhà cung cấp "công cụ" chuyên dụng (thông qua các MCP server). Bằng cách tách biệt mô hình AI khỏi các công cụ mà nó sử dụng, MCP cho phép mỗi bên tập trung vào thế mạnh của mình. Các công ty mô hình có thể tập trung vào việc cải thiện năng lực lý luận cốt lõi, trong khi các nhà cung cấp dịch vụ có thể "AI-hóa" sản phẩm của họ bằng cách cung cấp một MCP server, mở ra một kênh phân phối hoàn toàn mới.

Về bản chất, MCP đang thúc đẩy một sự "phân tách" (unbundling) trong chuỗi giá trị AI. Thay vì các hệ thống AI nguyên khối, chúng ta sẽ thấy một hệ sinh thái gồm các mô hình lý luận cốt lõi có thể "thuê" các khả năng chuyên biệt theo yêu cầu. Điều này sẽ thúc đẩy sự đổi mới nhanh hơn, vì các nhà cung cấp công cụ có thể cạnh tranh về chất lượng dịch vụ của họ, và người dùng cuối có thể kết hợp các công cụ tốt nhất từ nhiều nhà cung cấp khác nhau. MCP đang biến các AI agent từ những "công nhân đa năng" thành những "nhà quản lý dự án" có thể điều phối các chuyên gia (công cụ) bên ngoài.

Cuộc đua mô hình lớn: thách thức tin cậy và sự tỉnh táo sau cơn sốt HRM

Ngoài GPT-5, các đối thủ lớn khác cũng đang đối mặt với những thách thức riêng về độ tin cậy và nhận thức của thị trường. Tuần này đã làm sáng tỏ những nghịch lý trong chiến lược của Anthropic và mang lại một bài học quan trọng về sự cường điệu hóa kiến trúc mô hình thông qua trường hợp của HRM.

Claude và nghịch lý tin cậy

Anthropic đã và đang xây dựng thương hiệu Claude xung quanh các khái niệm về an toàn, đạo đức và độ tin cậy. Công ty nhấn mạnh các quy trình kiểm tra và đánh giá nghiêm ngặt, các khuôn khổ giảm thiểu tác hại và sự hợp tác với các chuyên gia để đảm bảo các mô hình của mình hoạt động một cách có trách nhiệm. [10] Mục tiêu là tạo ra một AI mà người dùng có thể tin tưởng để xử lý các nhiệm vụ phức tạp và nhạy cảm.

Tuy nhiên, một nghịch lý đang hiện hữu. Trong khi Anthropic tập trung vào việc tạo ra một mô hình "đáng tin cậy" về mặt đầu ra (output), cộng đồng nhà phát triển lại đang phải vật lộn với sự "không đáng tin cậy" về mặt khả dụng (availability) của nó. Các báo cáo cho thấy các sản phẩm như Claude Code phải chịu các giới hạn rate limit nghiêm ngặt, không thể đoán trước và các giới hạn sử dụng hàng tuần. Những hạn chế này làm giảm năng suất một cách đáng kể, đặc biệt là trong các giai đoạn làm việc cường độ cao như sprint, gỡ lỗi khẩn cấp hoặc tái cấu trúc dự án lớn. [11] Kết quả là, một mô hình được thiết kế để đáng tin cậy về mặt đạo đức lại trở nên không đáng tin cậy cho các quy trình làm việc chuyên nghiệp, nơi mà hiệu suất ổn định và có thể dự đoán là yếu tố sống còn. Điều này đặt ra câu hỏi về sự cân bằng giữa an toàn và khả năng sử dụng trong thực tế.

HRM và bài học về kiến trúc

Vài tháng trước, Mô hình Lý luận Phân cấp (Hierarchical Reasoning Model - HRM) đã tạo ra một cơn sốt trong cộng đồng nghiên cứu AI. Với kiến trúc được cho là lấy cảm hứng từ não bộ con người, bao gồm một mô-đun "Bộ điều khiển" cấp cao cho lý luận trừu tượng và một mô-đun "Công nhân" cấp thấp cho các tính toán chi tiết, HRM đã đạt được những kết quả ấn tượng trên các benchmark lý luận khó như ARC-AGI. [12]

Tuy nhiên, một phân tích sâu hơn được công bố gần đây, được thực hiện bởi nhóm của François Chollet tại ARC Prize, đã tiết lộ một sự thật đáng ngạc nhiên. Các thử nghiệm phân tách (ablation studies) của họ cho thấy rằng hiệu suất vượt trội của hệ thống không thực sự đến từ kiến trúc phân cấp độc đáo của HRM. Thay vào đó, một mô hình Transformer tiêu chuẩn với cùng số lượng tham số (~27 triệu) cũng đạt được kết quả gần như tương đương. [14]

Phân tích chỉ ra rằng động lực thực sự đằng sau hiệu suất ấn tượng là "quá trình vòng lặp ngoài" (outer loop process) và "huấn luyện tại thời điểm kiểm tra" (test-time training). Về cơ bản, đó là phương pháp huấn luyện và cách hệ thống lặp đi lặp lại việc đưa đầu ra của chính nó trở lại làm đầu vào để tự tinh chỉnh, chứ không phải là kiến trúc "hai não" đặc biệt. [14]

Thị trường AI đang trải qua một "cuộc khủng hoảng tin cậy" ở nhiều cấp độ khác nhau. Với GPT-5, đó là sự tin cậy về mặt kỹ thuật và trải nghiệm người dùng. Với Claude, đó là sự tin cậy về mặt khả dụng cho nhà phát triển. Và với HRM, đó là sự tin cậy vào các tuyên bố về sự đột phá trong kiến trúc mô hình. Tất cả những điều này cho thấy sự trưởng thành của thị trường, nơi người dùng và nhà nghiên cứu đang bắt đầu nhìn xa hơn các tuyên bố marketing và các bài báo gây sốc để đánh giá giá trị thực tế và các động lực cơ bản của hiệu suất. Ngành công nghiệp đang bước vào giai đoạn "hậu cường điệu", nơi các yếu tố nền tảng như phương pháp huấn luyện và độ tin cậy của hạ tầng được công nhận là quan trọng không kém gì các kiến trúc mô hình mới lạ.

GPT-5

Hiệu suất SOTA trên các benchmark lập trình, khoa học, y tế. [1] Khả năng lý luận vượt trội, giảm ảo giác. [1] Đạt huy chương vàng IMO. [2]

Mất ổn định kỹ thuật nghiêm trọng ("Error in message stream"). [1] Bị chỉ trích là "vô hồn", thiếu sáng tạo so với 4o. [1] Rate limit trên Azure bị giảm mạnh, ảnh hưởng đến khả năng sử dụng. [5]

Người dùng phổ thông, doanh nghiệp, nhà phát triển yêu cầu năng lực đỉnh cao.

Claude (Opus/Code)

Tập trung mạnh vào an toàn, đạo đức và giảm thiểu rủi ro. [10] Khả năng xử lý các tác vụ phức tạp, đa tệp trong các dự án lớn. [11]

Giới hạn rate limit nghiêm ngặt và không thể đoán trước, làm giảm năng suất của nhà phát triển. [11] Phụ thuộc vào API của bên thứ ba, gây lo ngại về độ trễ và tính sẵn sàng. [11]

Doanh nghiệp và nhà phát triển ưu tiên an toàn, tuân thủ và xử lý các tác vụ quy mô lớn.

Mistral Medium 3.1

Cân bằng giữa hiệu suất cao và chi phí vận hành thấp hơn 8 lần so với các mô hình lớn truyền thống. [16] Cải thiện về lý luận, lập trình và khả năng đa phương thức. [17]

Là một bản cập nhật, có thể không mang tính đột phá như một thế hệ hoàn toàn mới. Chi tiết về hiệu suất so với GPT-5 vẫn chưa được kiểm chứng rộng rãi.

Doanh nghiệp tìm kiếm giải pháp AI hiệu quả về chi phí, có thể tùy chỉnh và triển khai linh hoạt (hybrid, on-prem).

Chuyển động công nghệ: từ lý thuyết đến thực thi

Tuần này đã chứng kiến những bước tiến quan trọng trong việc biến các khái niệm AI tiên tiến thành các công cụ và kiến trúc có thể triển khai trong thực tế. Trọng tâm đang dịch chuyển từ việc chỉ tạo ra các mô hình có khả năng trả lời câu hỏi sang việc xây dựng các hệ thống có thể thực hiện hành động, hợp tác với con người và được hỗ trợ bởi một hệ sinh thái phần cứng-phần mềm toàn diện.

Sự trỗi dậy của Agentic RQG: AI không chỉ "biết", mà còn "làm"

Sự phát triển của AI doanh nghiệp đang bước vào một giai đoạn mới, vượt ra ngoài giới hạn của Retrieval-Augmented Generation (RAG) truyền thống.

● Bước tiến từ RAG truyền thống: RAG là một bước đột phá, cho phép các mô hình ngôn ngữ truy xuất thông tin từ các cơ sở kiến thức riêng của doanh nghiệp để đưa ra các câu trả lời chính xác và phù hợp với ngữ cảnh. Tuy nhiên, vai trò của nó chủ yếu dừng lại ở việc "cung cấp thông tin". [19] Nó có thể trả lời câu hỏi "Doanh thu quý trước là bao nhiêu?", nhưng nhân viên sau đó phải tự mình hành động dựa trên câu trả lời đó.

● Kỷ nguyên AI Hành động (Agentic AI): AI Hành động, hay Agentic RAG, là bước tiến hóa tiếp theo. Các hệ thống này không chỉ "biết" mà còn có thể "làm". Thay vì chỉ truy xuất thông tin, các agent có khả năng "lý luận, hành động và hợp tác" để hoàn thành các tác vụ trong thế giới thực. [19] Chúng có thể nhận một yêu cầu cấp cao như "Tạo báo cáo doanh thu quý trước và gửi cho ban giám đốc" và tự động thực hiện một chuỗi các hành động để hoàn thành nó.

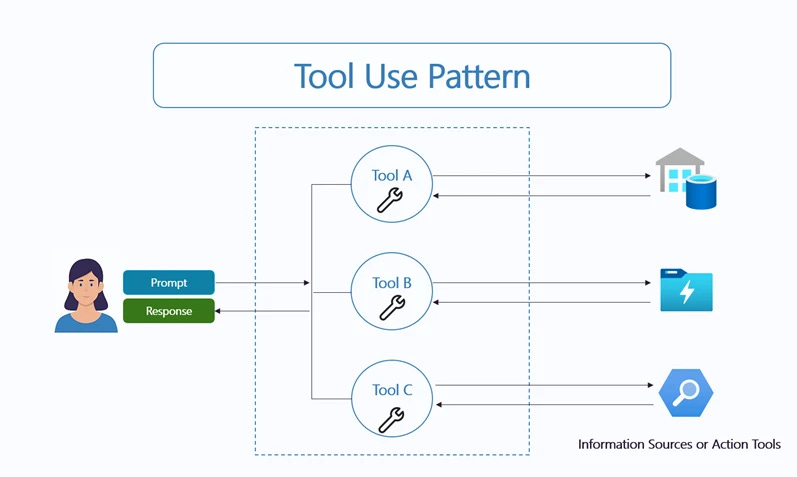

● Các mẫu thiết kế cơ bản: Việc xây dựng các hệ thống Agentic AI trong môi trường doanh nghiệp thường dựa trên một số mẫu (patterns) thiết kế cốt lõi đã được chứng minh là hiệu quả trong sản xuất:

○ Sử dụng công cụ (Tool Use): Đây là khả năng cơ bản nhất, nơi agent có thể tương tác trực tiếp với các hệ thống doanh nghiệp bằng cách gọi API, kích hoạt các quy trình tự động hóa, và thực thi các giao dịch. Fujitsu đã sử dụng các agent chuyên biệt để tự động hóa việc tạo đề xuất bán hàng, giảm thời gian sản xuất tới 67%. [19]

○ Tự phản tư (Reflection): Các agent tiên tiến có khả năng tự đánh giá và cải thiện kết quả đầu ra của chính mình. Chúng có thể tự động kiểm tra lại các phép tính, sửa lỗi chính tả, hoặc đảm bảo nội dung tuân thủ các tiêu chuẩn của công ty mà không cần sự can thiệp liên tục của con người. Điều này cực kỳ quan trọng trong các lĩnh vực có rủi ro cao như tài chính và tuân thủ. [19]

○ Lập kế hoạch (Planning): Đối với các quy trình kinh doanh phức tạp, các agent lập kế hoạch có thể chia nhỏ một mục tiêu lớn thành các nhiệm vụ con có thể quản lý được, theo dõi tiến độ và điều chỉnh kế hoạch khi có thay đổi. ContraForce đã tự động hóa 80% quy trình điều tra và ứng phó sự cố an ninh mạng bằng cách sử dụng các agent lập kế hoạch. [19]

○ Đa agent (Multi-agent): Tương tự như một đội ngũ con người, mẫu thiết kế này kết nối một mạng lưới các agent chuyên môn hóa, mỗi agent tập trung vào một giai đoạn cụ thể của quy trình làm việc, dưới sự điều phối của một agent chính. Điều này giúp hệ thống trở nên linh hoạt, dễ mở rộng và quản lý. [19]

Sự chuyển dịch sang Agentic RAG đánh dấu một sự thay đổi cơ bản trong vai trò của AI trong doanh nghiệp: từ một "trung tâm thông tin" thụ động thành một "lực lượng lao động kỹ thuật số" chủ động. Nó hứa hẹn một hình thức tự động hóa linh hoạt và có khả năng thích ứng cao hơn nhiều so với các công cụ tự động hóa quy trình kinh doanh (BPA) truyền thống, vốn thường cứng nhắc và dễ bị hỏng. Đây không còn là việc tự động hóa các tác vụ riêng lẻ, mà là tự động hóa toàn bộ các quy trình công việc phức tạp.

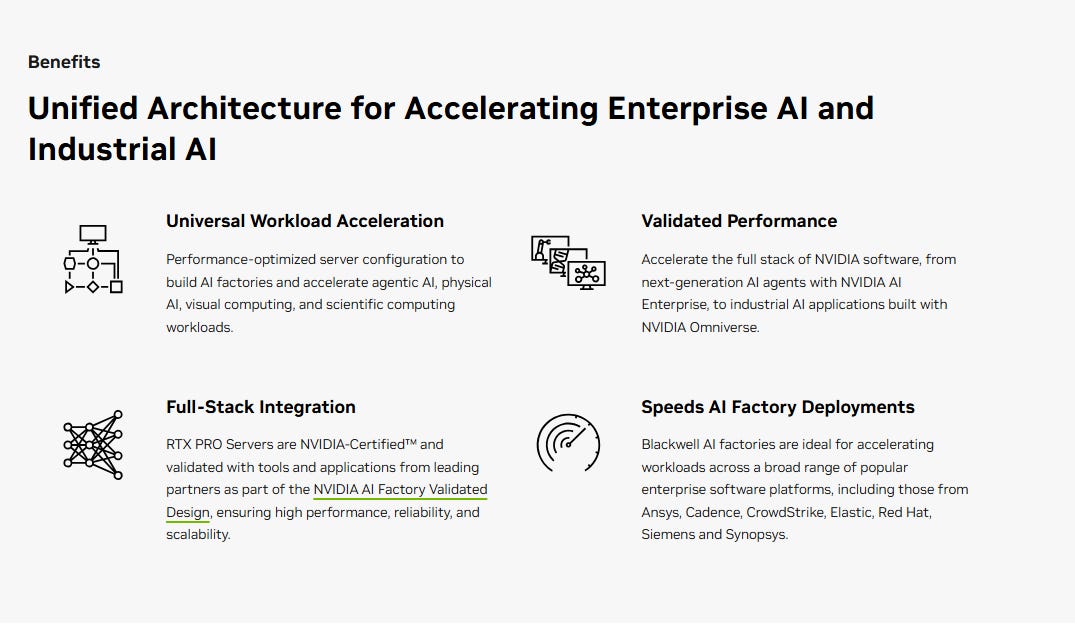

Hệ sinh thái NVIDIA và "Nhà máy AI" (AI Factory)

NVIDIA tiếp tục củng cố vị thế thống trị của mình không chỉ ở tầng phần cứng mà còn ở toàn bộ hệ sinh thái phần mềm và kiến trúc cần thiết để triển khai AI doanh nghiệp.

● Blueprint AI-Q: NVIDIA đã công bố AI-Q, một "blueprint" (bản thiết kế chi tiết) mới được thiết kế để giúp các doanh nghiệp phát triển, phân tích và tối ưu hóa các hệ thống đa agent. Đây không phải là một sản phẩm cụ thể mà là một bộ hướng dẫn kiến trúc và các công cụ tốt nhất để xây dựng các agent có khả năng hợp tác, phân tích và tạo ra dữ liệu doanh nghiệp ở quy mô lớn. [21]

● Chiến lược "Nhà máy AI" (AI Factory): AI-Q là một thành phần quan trọng trong tầm nhìn lớn hơn của NVIDIA về "Nhà máy AI". Đây là một khái niệm về một nền tảng điện toán tăng tốc toàn diện, từ đầu đến cuối, cho phép các doanh nghiệp triển khai cơ sở hạ tầng AI an toàn và sẵn sàng cho tương lai. Nền tảng này bao gồm phần cứng tiên tiến như kiến trúc Blackwell, DPU BlueField-3 và mạng Spectrum-X, kết hợp với các lớp phần mềm như NVIDIA AI Enterprise. [21]

● Hợp tác hệ sinh thái: Để thúc đẩy việc áp dụng, NVIDIA đang tích cực hợp tác với các công ty nền tảng dữ liệu doanh nghiệp hàng đầu như Dataiku. Sự hợp tác này cho phép tích hợp blueprint AI-Q và các vi dịch vụ NVIDIA NIM vào các nền tảng hiện có, giúp các công ty nhanh chóng triển khai các hệ thống agentic phức tạp trên cơ sở hạ tầng của họ một cách hiệu quả và tuân thủ. [22]

NVIDIA đang thực hiện một nước cờ chiến lược để chuyển mình từ một nhà cung cấp "cuốc và xẻng" (GPU) trong cơn sốt vàng AI thành nhà cung cấp "hệ điều hành" cho toàn bộ nền kinh tế AI. Blueprint AI-Q không chỉ là một tài liệu kỹ thuật; nó là một nỗ lực để thiết lập các tiêu chuẩn de facto cho cách xây dựng và triển khai AI hành động trong doanh nghiệp. Bằng cách cung cấp các bản thiết kế này, NVIDIA đang định hình kiến trúc của các ứng dụng AI thế hệ tiếp theo theo cách có lợi cho hệ sinh thái của họ. Nếu các doanh nghiệp áp dụng blueprint AI-Q, họ sẽ có xu hướng sử dụng toàn bộ stack của NVIDIA để đạt được hiệu suất tối ưu. Đây là một chiến lược kinh điển để chiếm lĩnh nền tảng: không chỉ bán các thành phần, mà còn định nghĩa cách các thành phần đó được lắp ráp với nhau, từ đó kiểm soát toàn bộ hệ sinh thái.

Xu hướng hợp tác người-ai và nghiên cứu mới

Trong bối cảnh các hệ thống AI ngày càng tự chủ, một xu hướng ngược lại cũng đang nổi lên, nhấn mạnh tầm quan trọng của sự hợp tác chặt chẽ giữa con người và máy móc.

● Magnetic UI của Microsoft: Thay vì theo đuổi mục tiêu tạo ra các agent hoàn toàn tự trị, một mục tiêu đầy rủi ro và khó đạt được, Microsoft đang khám phá một mô hình hợp tác Người-AI thông qua dự án Magnetic UI. Đây là một công cụ thử nghiệm cho phép người dùng và AI "cùng lập kế hoạch" (co-planning) và "cùng thực thi" (co-tasking) các nhiệm vụ trên web. Trước khi agent thực hiện bất kỳ hành động nào, nó sẽ trình bày một kế hoạch chi tiết mà người dùng có thể xem, chỉnh sửa và phê duyệt. Trong quá trình thực thi, người dùng có thể tạm dừng, đưa ra phản hồi bằng ngôn ngữ tự nhiên hoặc thậm chí trực tiếp can thiệp để hướng dẫn agent. Cách tiếp cận "con người trong vòng lặp" (human-in-the-loop) này nhằm giải quyết các vấn đề cố hữu của các agent tự trị như thiếu minh bạch, mất kiểm soát và thất bại khó lường. [13]

● Mô hình Ngôn ngữ Tự vấn (Self-Questioning Language Models): Một bài báo nghiên cứu mới với tiêu đề "Self-Questioning Language Models" đã được công bố, báo hiệu một hướng đi mới trong việc cải thiện khả năng lý luận của AI. [23] Mặc dù chi tiết kỹ thuật chưa được phân tích sâu, khái niệm này gợi ý về việc phát triển các mô hình có khả năng tự đặt ra các câu hỏi làm rõ hoặc các câu hỏi trung gian để phân rã một vấn đề phức tạp trước khi đưa ra câu trả lời cuối cùng. Đây là một cơ chế bắt chước cách con người suy nghĩ và giải quyết vấn đề, có khả năng làm tăng độ chính xác và độ tin cậy của các câu trả lời.

Những phát triển này cho thấy ngành công nghiệp đang nhận ra rằng "tự trị hoàn toàn" có thể không phải là mục tiêu cuối cùng hoặc thậm chí không phải là mục tiêu mong muốn cho nhiều ứng dụng quan trọng. Thay vào đó, một mô hình "hợp tác thông minh", trong đó AI tăng cường khả năng của con người thay vì thay thế con người, đang nổi lên như một hướng đi thực tế, an toàn và hiệu quả hơn. Vai trò của con người đang chuyển từ một "người dùng cuối" ra lệnh một cách thụ động thành một "người giám sát và cộng tác viên" tích cực trong một vòng lặp phản hồi liên tục. Điều này không chỉ giúp tăng độ tin cậy của hệ thống mà còn giải quyết các vấn đề phức tạp về trách nhiệm và an toàn trong kỷ nguyên AI.

Tác động thị trường: dòng vốn, nhân sự và sự phá vỡ

Tuần qua đã chứng kiến những biến động đáng kể trên thị trường AI, từ các động thái chiến lược của các tỷ phú công nghệ cho đến sự thay đổi cấu trúc trong các ngành công nghiệp lâu đời. Những sự kiện này phản ánh một thị trường đang trưởng thành, nơi các cuộc đối đầu không chỉ diễn ra ở cấp độ công nghệ mà còn ở cấp độ ý thức hệ và mô hình kinh doanh.

Thung lũng silicon tái cấu trúc: cuộc đối đầu altman-musk và làn sóng an toàn AI

Cuộc cạnh tranh và khác biệt về tầm nhìn giữa các nhà lãnh đạo hàng đầu của Thung lũng Silicon tiếp tục định hình lại bối cảnh AI.

● Cuộc đối đầu Giao diện não-máy tính (BCI): Cuộc cạnh tranh giữa Sam Altman (CEO OpenAI) và Elon Musk đã leo thang sang một mặt trận mới. Có thông tin cho rằng Sam Altman đang tham gia vào việc ra mắt Merge Labs, một công ty khởi nghiệp về BCI với mục tiêu cạnh tranh trực tiếp với Neuralink của Elon Musk. OpenAI được cho là đang cân nhắc một khoản đầu tư lớn vào công ty này, với mục tiêu tạo ra các giao diện não-máy tính ít xâm lấn hơn và có băng thông cao để tích hợp rộng rãi giữa con người và AI. [26] Động thái này cho thấy tham vọng của Altman không chỉ dừng lại ở các mô hình ngôn ngữ mà còn hướng tới việc hợp nhất sâu hơn giữa con người và máy móc.

● Sự ra đi của Igor Babuschkin (xAI) và sự trỗi dậy của An toàn AI: Một sự kiện quan trọng khác là việc Igor Babuschkin, một trong những thành viên sáng lập của xAI (công ty AI của Elon Musk), đã tuyên bố rời công ty. [28] Đáng chú ý, ông không chuyển sang một đối thủ cạnh tranh trực tiếp mà thành lập Babuschkin Ventures, một quỹ đầu tư mạo hiểm mới tập trung hoàn toàn vào việc tài trợ cho nghiên cứu an toàn AI và các hệ thống agentic có lợi cho nhân loại. [27] Trong tuyên bố của mình, Babuschkin nhấn mạnh sự cần thiết phải đảm bảo rằng công nghệ AI, khi ngày càng trở nên mạnh mẽ, được sử dụng cho mục đích tốt và an toàn. [30]

Những động thái này không chỉ là những câu chuyện kinh doanh riêng lẻ mà là biểu hiện của một sự phân mảnh về ý thức hệ trong giới lãnh đạo AI. Có thể thấy ba phe phái chính đang dần hình thành:

(1) Phe "Tăng tốc" (Accelerationists) do OpenAI dẫn đầu, tập trung vào việc đẩy nhanh năng lực của AI đến giới hạn;

(2) Phe "Thương mại hóa" như xAI, tập trung vào việc tích hợp AI chặt chẽ vào các sản phẩm hiện có để tạo ra lợi thế cạnh tranh;

và (3) Phe "An toàn là trên hết" (Safety-First), ngày càng có ảnh hưởng, cho rằng việc kiểm soát rủi ro và xây dựng các biện pháp bảo vệ phải đi trước khi mở rộng quy mô.

Sự ra đời của Babuschkin Ventures là một tín hiệu mạnh mẽ rằng mối quan tâm về an toàn không còn là một chủ đề ngoài lề mà đã trở thành một con đường sự nghiệp và một luận điểm đầu tư khả thi. Điều này có thể tạo ra một "lối thoát" cho các nhà nghiên cứu tài năng tại các phòng thí nghiệm lớn, những người cảm thấy công ty của họ đang di chuyển quá nhanh mà không quan tâm đầy đủ đến các biện pháp an toàn, có khả năng dẫn đến một cuộc "chảy máu chất xám" và tạo ra một hệ sinh thái đối trọng tập trung vào việc phát triển các công nghệ và tiêu chuẩn an toàn cho toàn ngành.

Big Four chuyển mình: AI tái định nghĩa ngành dịch vụ chuyên nghiệp

Sự đột phá của AI không chỉ giới hạn trong lĩnh vực công nghệ cao mà còn đang tạo ra những cơn địa chấn trong các ngành công nghiệp truyền thống, đặc biệt là ngành dịch vụ chuyên nghiệp, nơi các "ông lớn" của nhóm Big Four (PwC, KPMG, Deloitte, EY) đang phải đối mặt với một cuộc tái định nghĩa cơ bản.

● Phá vỡ mô hình kim tự tháp: Mô hình kinh doanh cốt lõi của Big Four trong nhiều thập kỷ qua được xây dựng trên cấu trúc nhân sự hình kim tự tháp (nhiều nhân viên cấp dưới thực hiện các công việc lặp đi lặp lại, và một số ít đối tác cấp cao quản lý) và mô hình tính phí dựa trên "giờ làm việc" (billable hours). AI đang tấn công trực tiếp vào nền tảng này. Các công cụ AI, đặc biệt là AI hành động, đang tự động hóa một phần lớn các công việc cốt lõi, nặng về dữ liệu như kiểm toán, tuân thủ thuế, và thẩm định doanh nghiệp. [34] KPMG đã sử dụng AI để quét hàng triệu bút toán kế toán, và EY có một nền tảng AI hỗ trợ 80,000 chuyên gia thuế xử lý hàng triệu trường hợp tuân thủ mỗi năm. [35]

● Tái định nghĩa vai trò nhân viên: Sự thay đổi này buộc các công ty phải suy nghĩ lại hoàn toàn về vai trò và con đường sự nghiệp của nhân viên.

○ Đối với nhân viên cấp dưới (Junior): Vai trò của họ đang chuyển từ "người thực thi" sang "người giám sát". Một nhà lãnh đạo tại PwC dự đoán rằng trong vòng ba năm, một nhân viên mới vào nghề sẽ thực hiện các công việc tương đương với một quản lý ngày nay. Thay vì học cách thực hiện các tác vụ kiểm toán cơ bản, họ sẽ được đào tạo sớm hơn về các kỹ năng cấp cao như tư duy phản biện, hoài nghi nghề nghiệp và đàm phán, trong khi công việc thu thập và xử lý dữ liệu được giao cho AI. [34]

○ Đối với nhân viên cấp cao (Senior): Các đối tác và quản lý đang phải đối mặt với áp lực từ khách hàng. Khách hàng bắt đầu đặt câu hỏi tại sao họ phải trả mức phí cao cho hàng giờ làm việc của con người khi một công cụ AI có thể đưa ra câu trả lời "gần như ngay lập tức". [34]

● Phản ứng của ngành: Nhận thức được mối đe dọa, các công ty Big Four đang đầu tư mạnh mẽ vào công nghệ. Deloitte đã ra mắt Zora AI, một nền tảng công cụ hành động [35], và lãnh đạo của KPMG cũng đã công khai tuyên bố sự cần thiết phải triển khai "agentic AI" một cách nhanh chóng và có trách nhiệm để duy trì tính cạnh tranh. [36]

Sự chuyển đổi này không chỉ là về việc cải thiện hiệu quả hoạt động; nó là một cuộc khủng hoảng hiện sinh đối với ngành dịch vụ chuyên nghiệp. Giá trị của họ không còn nằm ở việc thực hiện công việc một cách hiệu quả, mà phải chuyển sang khả năng phán đoán, tư vấn chiến lược và quản lý sự thay đổi. Họ phải chuyển đổi từ vị thế của một "nhà cung cấp dịch vụ" sang một "nhà tích hợp công nghệ và cố vấn chiến lược". Thách thức lớn nhất đối với họ không phải là công nghệ, mà là văn hóa tổ chức: làm thế nào để chuyển đổi một lực lượng lao động hàng trăm nghìn người từ tư duy "tuân thủ quy trình" sang tư duy "đổi mới và giải quyết vấn đề". Đây là một sự thay đổi khổng lồ và đầy rủi ro, và những công ty không thể thích ứng có nguy cơ bị các công ty tư vấn công nghệ nhanh nhẹn hơn hoặc các nền tảng SaaS (Software as a Service) chuyên biệt chiếm lấy thị phần.

Cập nhật nền tảng và sản phẩm

Tuần qua cũng là một tuần sôi động với các bản cập nhật sản phẩm quan trọng từ các công ty AI hàng đầu, cho thấy cuộc đua tính năng vẫn đang diễn ra quyết liệt nhằm thu hút và giữ chân người dùng.

● Perplexity tham gia cuộc đua video: Công ty công cụ tìm kiếm AI Perplexity đã chính thức bước vào thị trường tạo video từ văn bản, một lĩnh vực đang ngày càng trở nên đông đúc. Tính năng mới này, dành riêng cho các thuê bao trả phí (Pro và Max), cho phép người dùng tạo ra các video clip ngắn dài 8 giây, có kèm âm thanh, chỉ từ các câu lệnh văn bản đơn giản. Tính năng này có sẵn trên cả web và ứng dụng di động đã được cập nhật. Động thái này đặt Perplexity vào thế cạnh tranh trực tiếp với các sản phẩm như Veo 3 của Google và Sora của OpenAI, cho thấy chiến lược của công ty là mở rộng ra ngoài lĩnh vực tìm kiếm để trở thành một nền tảng AI đa năng hơn. [37]

● Mistral Medium 3.1 tập trung vào doanh nghiệp: Công ty AI châu Âu Mistral đã phát hành Mistral Medium 3.1, một bản cập nhật quan trọng cho mô hình cấp doanh nghiệp của mình. Bản cập nhật này mang lại những cải tiến toàn diện về hiệu suất, bao gồm khả năng lý luận, lập trình và xử lý đa phương thức tốt hơn. Mistral định vị Medium 3.1 là một giải pháp hiệu quả về chi phí, cung cấp hiệu suất cạnh tranh so với các mô hình lớn hơn như Claude Sonnet 3.7 và Llama 4 Maverick, nhưng với chi phí vận hành thấp hơn tới 8 lần. Mô hình này cũng được tối ưu hóa cho các kịch bản triển khai linh hoạt trong doanh nghiệp, bao gồm cả hybrid, tại chỗ (on-premise) và trong VPC. Người dùng có thể trải nghiệm mô hình mới này thông qua chatbot Le Chat hoặc qua API. [16]

● Gemini có "trí nhớ" lâu dài: Google đã bắt đầu triển khai một tính năng được mong đợi từ lâu cho chatbot Gemini của mình, có tên là "Personal Context". Tính năng này, được bật theo mặc định, cho phép Gemini tự động ghi nhớ các chi tiết quan trọng và sở thích của người dùng từ các cuộc trò chuyện trước đó. Mục tiêu là để cung cấp các câu trả lời được cá nhân hóa và phù hợp hơn theo thời gian, mà không cần người dùng phải nhắc lại thông tin. Ví dụ, nếu bạn đã từng thảo luận về một bộ truyện tranh, Gemini có thể gợi ý một chủ đề tiệc sinh nhật dựa trên nhân vật yêu thích của bạn. Chức năng này tương tự như tính năng "Memory" mà OpenAI đã giới thiệu cho ChatGPT trước đó. Để đảm bảo quyền riêng tư, Google cũng giới thiệu chế độ "Temporary Chats", cho phép người dùng có những cuộc trò chuyện không được lưu lại hoặc sử dụng để cá nhân hóa. [40]

● Các công cụ và mô hình nhỏ hơn: Bên cạnh các mô hình khổng lồ, tuần này cũng chứng kiến sự ra mắt của nhiều công cụ và mô hình nhỏ hơn, chuyên dụng hơn. NVIDIA đã phát hành các mô hình Canary-1b-v2 và Parakeet-tdt-0.6b-v3, được tối ưu hóa cho việc nhận dạng và dịch giọng nói đa ngôn ngữ. [47] Các nhà nghiên cứu cũng công bố GBiDC-PEST, một mô hình nhẹ để phát hiện sâu bệnh trên thiết bị di động [49], và Dots.ocr, một mô hình OCR kích thước nhỏ nhưng hiệu suất cao. [50] Sự phát triển này cho thấy một xu hướng quan trọng: tương lai của AI không chỉ nằm ở các mô hình khổng lồ trên đám mây, mà còn ở các mô hình nhỏ, hiệu quả và có thể chạy trực tiếp trên các thiết bị cạnh (edge devices).

Nhận định chiến lược: kỷ nguyên của sự tin cậy

Nhìn lại toàn bộ các sự kiện trong tuần, từ sự cố ra mắt của GPT-5, sự trỗi dậy của các tiêu chuẩn như MCP, cho đến sự thay đổi cấu trúc trong ngành tư vấn, tất cả đều hội tụ về một chủ đề trung tâm và cấp bách: sự tin cậy. Thị trường AI không còn chỉ bị mê hoặc bởi tiềm năng và các chỉ số benchmark ấn tượng; giờ đây, nó đòi hỏi bằng chứng về hiệu suất ổn định, có thể dự đoán và an toàn trong các ứng dụng của thế giới thực.

Cuộc đua AI đang trải qua một sự chuyển dịch trọng tâm quan trọng. Nó không còn chỉ là cuộc đua xây dựng các mô hình có năng lực lý luận cao nhất, mà đã trở thành cuộc đua xây dựng các hệ thống AI toàn diện và đáng tin cậy. Một hệ thống như vậy không chỉ bao gồm một mô hình mạnh mẽ, mà còn đòi hỏi một cơ sở hạ tầng vững chắc có thể đáp ứng nhu cầu tính toán, các giao thức được tiêu chuẩn hóa như MCP để đảm bảo khả năng tương tác, các vòng lặp phản hồi với con người như Magnetic UI để đảm bảo sự kiểm soát và an toàn, và các quy trình quản trị rủi ro rõ ràng để xây dựng niềm tin.

Trong những tháng tới, có thể dự đoán rằng sự đầu tư và đổi mới sẽ ngày càng tăng vào các lĩnh vực "ít hào nhoáng" hơn nhưng lại cực kỳ quan trọng này. Các công ty có thể cung cấp một "cam kết về độ tin cậy" bao gồm tính ổn định của dịch vụ, hiệu suất có thể dự đoán, tính minh bạch trong hoạt động và các biện pháp bảo vệ an toàn mạnh mẽ sẽ có lợi thế cạnh tranh đáng kể so với những công ty chỉ tập trung vào việc phá vỡ các kỷ lục benchmark. Kỷ nguyên của sự cường điệu hóa đang dần nhường chỗ cho kỷ nguyên của sự tin cậy.

Tài liệu tham khảo

Các tài liệu tham khảo theo định dạng IEEE và truy cập được vào ngày 16/08/2025

[1] Ralabs, "GPT-5 Release: Smarter, Faster & More Adaptive AI," Ralabs Blog, 2025. [Trực tuyến]. Có sẵn: https://ralabs.org/blog/gpt5-is-here-this-is-what-changes/ [Truy cập: 16 tháng 8, 2025].

[2] S. Aaronson, "Updates!," Shtetl-Optimized Blog, 2025. [Trực tuyến]. Có sẵn:

https://scottaaronson.blog/?p=9047 [Truy cập: 16 tháng 8, 2025].

[3] "OpenAI: We've scored highly enough to achieve gold at this year's IOI online competition with a reasoning system," Reddit - r/singularity, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/singularity/comments/1mnkmwq/openai_weve_scored_highly_enough_to_achieve_gold/ [Truy cập: 16 tháng 8, 2025].

[4] "Capabilities of GPT-5 on Multimodal Medical Reasoning," Reddit - r/deeplearning, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/deeplearning/new/ [Truy cập: 16 tháng 8, 2025].

[5] Microsoft, "GPT 5 Rate Limits Decreased!," Microsoft Q&A, 2025. [Trực tuyến]. Có sẵn: https://learn.microsoft.com/en-ie/answers/questions/5518655/gpt-5-rate-limits-decreased [Truy cập: 16 tháng 8, 2025].

[6] Amazon Web Services, "Flexibility to Framework: Building MCP Servers with Controlled Tool Orchestration," AWS DevOps Blog, 2025. [Trực tuyến]. Có sẵn: https://aws.amazon.com/blogs/devops/flexibility-to-framework-building-mcp-servers-with-controlled-tool-orchestration/ [Truy cập: 16 tháng 8, 2025].

[7] Microsoft, "Use MCP servers (Preview) - Visual Studio (Windows)," Microsoft Learn, 2025. [Trực tuyến]. Có sẵn: https://learn.microsoft.com/en-us/visualstudio/ide/mcp-servers?view=vs-2022 [Truy cập: 16 tháng 8, 2025].

[8] Futran Solutions, "Building AI Workflows with the Model Context Protocol," Futran Solutions Blog, 2025. [Trực tuyến]. Có sẵn: https://futransolutions.com/blog/building-ai-workflows-with-the-model-context-protocol/ [Truy cập: 16 tháng 8, 2025].

[9] "Claude Sonnet 4 now supports 1M tokens of context," Hacker News, 2025. [Trực tuyến]. Có sẵn: https://news.ycombinator.com/item?id=44878147 [Truy cập: 16 tháng 8, 2025].

[10] Anthropic, "Building Safeguards for Claude," Anthropic News, 2025. [Trực tuyến]. Có sẵn: https://www.anthropic.com/news/building-safeguards-for-claude [Truy cập: 16 tháng 8, 2025].

[11] Northflank, "Claude Code vs Cursor: Complete comparison guide in 2025," Northflank Blog, 2025. [Trực tuyến]. Có sẵn: https://northflank.com/blog/claude-code-vs-cursor-comparison [Truy cập: 16 tháng 8, 2025].

[12] "The Weirdly Small AI That Cracks Reasoning Puzzles [HRM]," YouTube, 2025. [Video trực tuyến]. [Truy cập: 16 tháng 8, 2025].

[13] "AI Society 8.11.25 — Human Reasoning, Agent Collaboration & AI Bias," Medium, 2025. [Trực tuyến]. Có sẵn: https://medium.com/a-i-society/ai-society-8-11-25-human-reasoning-agent-collaboration-ai-bias-316ac10e7f5e [Truy cập: 16 tháng 8, 2025].

[14] "HRM flops on ARC-AGI, a regular transformer gets nearly the same score," Reddit - r/singularity, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/singularity/comments/1mr80l2/hrm_flops_on_arcagi_a_regular_transformer_gets/ [Truy cập: 16 tháng 8, 2025].

[15] "The Hidden Drivers of HRM's Performance on ARC-AGI (Chollet et al)," Reddit - r/accelerate, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/accelerate/comments/1mrdgj5/the_hidden_drivers_of_hrms_performance_on_arcagi/ [Truy cập: 16 tháng 8, 2025].

[16] OpenRouter, "Mistral Medium 3.1 - API, Providers, Stats," OpenRouter, 2025. [Trực tuyến]. Có sẵn: https://openrouter.ai/mistralai/mistral-medium-3.1 [Truy cập: 16 tháng 8, 2025].

[17] "Mistral AI," Reddit - r/MistralAI, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/MistralAI/hot/ [Truy cập: 16 tháng 8, 2025].

[18] AIBase News, "Mistral AI Launches Medium 3.1: Making AI Smarter and More Understanding of You!," AIBase News, 2025. [Trực tuyến]. Có sẵn: https://news.aibase.com/news/20523 [Truy cập: 16 tháng 8, 2025].

[19] Microsoft Azure, "Agent Factory: The new era of agentic AI—common use cases and design patterns," Azure Blog, 2025. [Trực tuyến]. Có sẵn: https://azure.microsoft.com/en-us/blog/agent-factory-the-new-era-of-agentic-ai-common-use-cases-and-design-patterns/ [Truy cập: 16 tháng 8, 2025].

[20] "AI Agent Roundup: 20+ Launches, Funding Rounds & Breakthroughs This Week," Medium, 2025. [Trực tuyến]. Có sẵn: https://medium.com/@agencyai/ai-agent-roundup-20-launches-funding-rounds-breakthroughs-this-week-06a959353e64 [Truy cập: 16 tháng 8, 2025].

[21] NVIDIA, "RTX PRO Servers for Building Enterprise AI Factories," NVIDIA Data Center, 2025. [Trực tuyến]. Có sẵn: https://www.nvidia.com/en-us/data-center/products/rtx-pro-server/ [Truy cập: 16 tháng 8, 2025].

[22] J. Song, "From Big Data Stream Processing to AI-Native Agents: Technical Evolution with Dataiku, StreamSets, and n8n," Jimmy Song Blog, 2025. [Trực tuyến]. Có sẵn: https://jimmysong.io/en/blog/big-data-stream-processing-vs-ai-agent/ [Truy cập: 16 tháng 8, 2025].

[23] "Have you heard these exciting AI news? - August 15, 2025 AI Updates Weekly," YouTube, 2025. [Video trực tuyến]. [Truy cập: 16 tháng 8, 2025].

[24] "Deep Learning Monitor - Find new Arxiv papers, tweets and Reddit posts for you," DeepLearn.org, 2025. [Trực tuyến]. Có sẵn: https://deeplearn.org/, [Truy cập: 16 tháng 8, 2025].

[25] "Have you heard these exciting AI news? - August 15, 2025 AI Updates Weekly," YouTube, 2025. [Video trực tuyến]. [Truy cập: 16 tháng 8, 2025].

[26] Yahoo News Canada, "OpenAI and Sam Altman Are Reportedly Working on a Neuralink Competitor," Yahoo News, 2025. [Trực tuyến]. Có sẵn: https://ca.news.yahoo.com/openai-sam-altman-reportedly-working-205324938.html [Truy cập: 16 tháng 8, 2025].

[27] MLQ.ai, "News Feed - MLQ.ai | Stocks," MLQ.ai, 2025. [Trực tuyến]. Có sẵn: https://mlq.ai/news/ [Truy cập: 16 tháng 8, 2025].

[28] Times of India, "Who is Igor Babuschkin? Co-founder of Elon Musk's xAI leaving to launch a new AI safety venture," Times of India, 2025. [Trực tuyến]. Có sẵn: https://timesofindia.indiatimes.com/technology/tech-news/who-is-igor-babuschkin-co-founder-of-elon-musks-xai-leaving-to-launch-a-new-ai-safety-venture/articleshow/123297185.cms [Truy cập: 16 tháng 8, 2025].

[29] Entrepreneur, "xAI Cofounder Says He Learned 2 Major Lessons From Elon Musk," Entrepreneur, 2025. [Trực tuyến]. Có sẵn: https://www.entrepreneur.com/business-news/xai-cofounder-says-he-learned-2-major-lessons-from-elon-musk/495933 [Truy cập: 16 tháng 8, 2025].

[30] Times of India, "Igor Babuschkin, co-founder of Elon Musk's AI startup, xAI resigns; shares a long 'last day thanks note' on Twitter," Times of India, 2025. [Trực tuyến]. Có sẵn: https://timesofindia.indiatimes.com/technology/tech-news/igor-babuschkin-co-founder-of-elon-musks-ai-startup-xai-resigns-shares-a-long-last-day-thanks-note-on-twitter-elon-had-warned-of-the-/articleshow/123297205.cms [Truy cập: 16 tháng 8, 2025].

[31] "xAI co-founder departs the company," Reddit - r/singularity, 2025. [Trực tuyến]. Có sẵn: https://www.reddit.com/r/singularity/comments/1mpk0re/xai_cofounder_departs_the_company/ [Truy cập: 16 tháng 8, 2025].

[32] Observer, "Elon Musk's xAI Loses Co-Founder Igor Babuschkin," Observer, 2025. [Trực tuyến]. Có sẵn: https://observer.com/2025/08/elon-musk-xai-loses-co-founder-igor-babushkin/ [Truy cập: 16 tháng 8, 2025].

[33] The Decoder, "A conversation with Max Tegmark inspired AI co-founder Igor Babuschkin shift to safer AI," The Decoder, 2025. [Trực tuyến]. Có sẵn: https://the-decoder.com/a-conversation-with-max-tegmark-inspired-ai-co-founder-igor-babuschkin-shift-to-safer-ai/ [Truy cập: 16 tháng 8, 2025].

[34] Times of India, "'People are going to walk in the door and almost instantaneously become' says Jenn Kosar, AI Assurance Leader at PwC on junior hires," Times of India, 2025. [Trực tuyến]. Có sẵn: https://timesofindia.indiatimes.com/technology/tech-news/people-are-going-to-walk-in-the-door-and-almost-instantaneously-become-says-jenn-kosar-ai-assurance-leader-at-pwc-on-junior-hires/articleshow/123215435.cms [Truy cập: 16 tháng 8, 2025].

[35] O. Khatib, "AI and the Collapse of the Big Four?," Medium, tháng 8 2025. [Trực tuyến]. Có sẵn: https://medium.com/@olikhatib/ai-and-the-collapse-of-the-big-four-1ed3472e08ed [Truy cập: 16 tháng 8, 2025].

[36] KPMG, "KPMG LLP Announces Industry and Sector Leaders," KPMG Press Release, 2025. [Trực tuyến]. Có sẵn: https://kpmg.com/us/en/media/news/kpmg-llp-names-industry-and-sector-leaders.html [Truy cập: 16 tháng 8, 2025].

[37] Winbuzzer, "Perplexity Enters AI Video Race, Offering Generation with Audio to Premium Subscribers," Winbuzzer, 2025. [Trực tuyến]. Có sẵn: https://winbuzzer.com/2025/08/14/perplexity-enters-ai-video-race-offering-generation-with-audio-to-premium-subscribers-xcxwbn/ [Truy cập: 16 tháng 8, 2025].

[38] Geekflare, "Perplexity Rolls Out Video Creation with Audio," Geekflare, 2025. [Trực tuyến]. Có sẵn: https://geekflare.com/news/perplexity-rolls-out-video-creation-with-audio/ [Truy cập: 16 tháng 8, 2025].

[39] The Rundown AI, "Apple plots AI comeback with home robots," The Rundown AI, 2025. [Trực tuyến]. Có sẵn: https://www.therundown.ai/p/apple-plots-ai-comeback-with-home-robots [Truy cập: 16 tháng 8, 2025].

[40] Economic Times, "Google's Gemini gets 'memory' upgrade and 'temporary chats'," Economic Times, 2025. [Trực tuyến]. Có sẵn: https://economictimes.indiatimes.com/tech/artificial-intelligence/googles-gemini-gets-memory-upgrade-and-temporary-chats/articleshow/123303351.cms [Truy cập: 16 tháng 8, 2025].

[41] Times of India, "Google brings new Gemini app updates; adds personalized chats, privacy controls and more," Times of India, 2025. [Trực tuyến]. Có sẵn: https://timesofindia.indiatimes.com/technology/tech-news/google-brings-new-gemini-app-updates-adds-personalized-chats-privacy-controls-and-more/articleshow/123298876.cms [Truy cập: 16 tháng 8, 2025].

[42] CNET, "Gemini Is Going to Start Learning More About You. Here's How to Turn That Off," CNET, 2025. [Trực tuyến]. Có sẵn: https://www.cnet.com/tech/services-and-software/gemini-is-going-to-start-learning-more-about-you-heres-how-to-turn-that-off/ [Truy cập: 16 tháng 8, 2025].

[43] Google, "Gemini adds Temporary Chats and new personalization features," Google Blog, 2025. [Trực tuyến]. Có sẵn: https://blog.google/products/gemini/temporary-chats-privacy-controls/ [Truy cập: 16 tháng 8, 2025].

[44] Android Authority, "New Gemini features will give the chatbot a better memory, but also selective amnesia," Android Authority, 2025. [Trực tuyến]. Có sẵn: https://www.androidauthority.com/new-gemini-features-remember-forget-conversations-3587288/ [Truy cập: 16 tháng 8, 2025].

[45] Android Central, "Gemini app's 'personal context' uses your old chats for future, personalized answers," Android Central, 2025. [Trực tuyến]. Có sẵn: https://www.androidcentral.com/apps-software/ai/gemini-app-personal-context-uses-old-chats-future-personalized-answers-update [Truy cập: 16 tháng 8, 2025].

[46] Lifewire, "Gemini Can Now Remember Your Old Chats… or Completely Forget," Lifewire, 2025. [Trực tuyến]. Có sẵn: https://www.lifewire.com/gemini-adds-personal-context-and-one-off-chats-11790013 [Truy cập: 16 tháng 8, 2025].

[47] HPCwire, "NVIDIA Releases Open Dataset, Models for Multilingual Speech AI," HPCwire, 2025. [Trực tuyến]. Có sẵn: https://www.hpcwire.com/off-the-wire/nvidia-releases-open-dataset-models-for-multilingual-speech-ai/ [Truy cập: 16 tháng 8, 2025].

[48] SiliconANGLE, "Nvidia releases massive AI-ready European language dataset and tools," SiliconANGLE, 2025. [Trực tuyến]. Có sẵn: https://siliconangle.com/2025/08/15/nvidia-releases-massive-high-quality-ai-ready-european-language-dataset-tools/ [Truy cập: 16 tháng 8, 2025].

[49] EurekAlert!, "GBiDC-PEST: A novel lightweight model for real-time multiclass tiny pest detection and mobile platform deployment," EurekAlert!, 2025. [Trực tuyến]. Có sẵn: https://www.eurekalert.org/news-releases/1094366 [Truy cập: 16 tháng 8, 2025].

[50] M. Gupta, "Dots.ocr : The best small-sized OCR ever," Data Science in Your Pocket, Medium, 2025. [Trực tuyến]. Có sẵn: https://medium.com/data-science-in-your-pocket/dots-ocr-the-best-small-sized-ocr-ever-b069d92153c2 [Truy cập: 16 tháng 8, 2025].