DeepSeek V3.2: thêm một cơn sốt model, hay một cú lệch trục thật sự?

DeepSeek V3.2 xuất hiện như một cơn gió mạnh thổi vào thế giới open source: một model reasoning và agentic đủ sức thi các kỳ IMO, IOI, ICPC, lại mở cho gần như mọi người.

Sáng nay dạy sớm, tầm 3h, mở laptop lướt X ra là thấy anh em công nghệ đăng dồn dập: “DeepSeek V3.2(special)”

Timeline toàn chữ “massive”, “nuts”, “GPT 5 level reasoning”, “open source bắt kịp closed source”. Cảm giác rất quen. Mỗi lần có model mới, không khí lại giống mấy năm bong bóng bất động sản: ai cũng thì thầm với nhau “khu này sắp lên rồi, vào nhanh kẻo muộn”.

Nhưng lần này có cái gì đó… lệch trục.

1. Luận điểm chính: không chỉ là model mới, mà là thế cân bằng mới

Tôi tóm cho bạn hai ý rất ngắn:

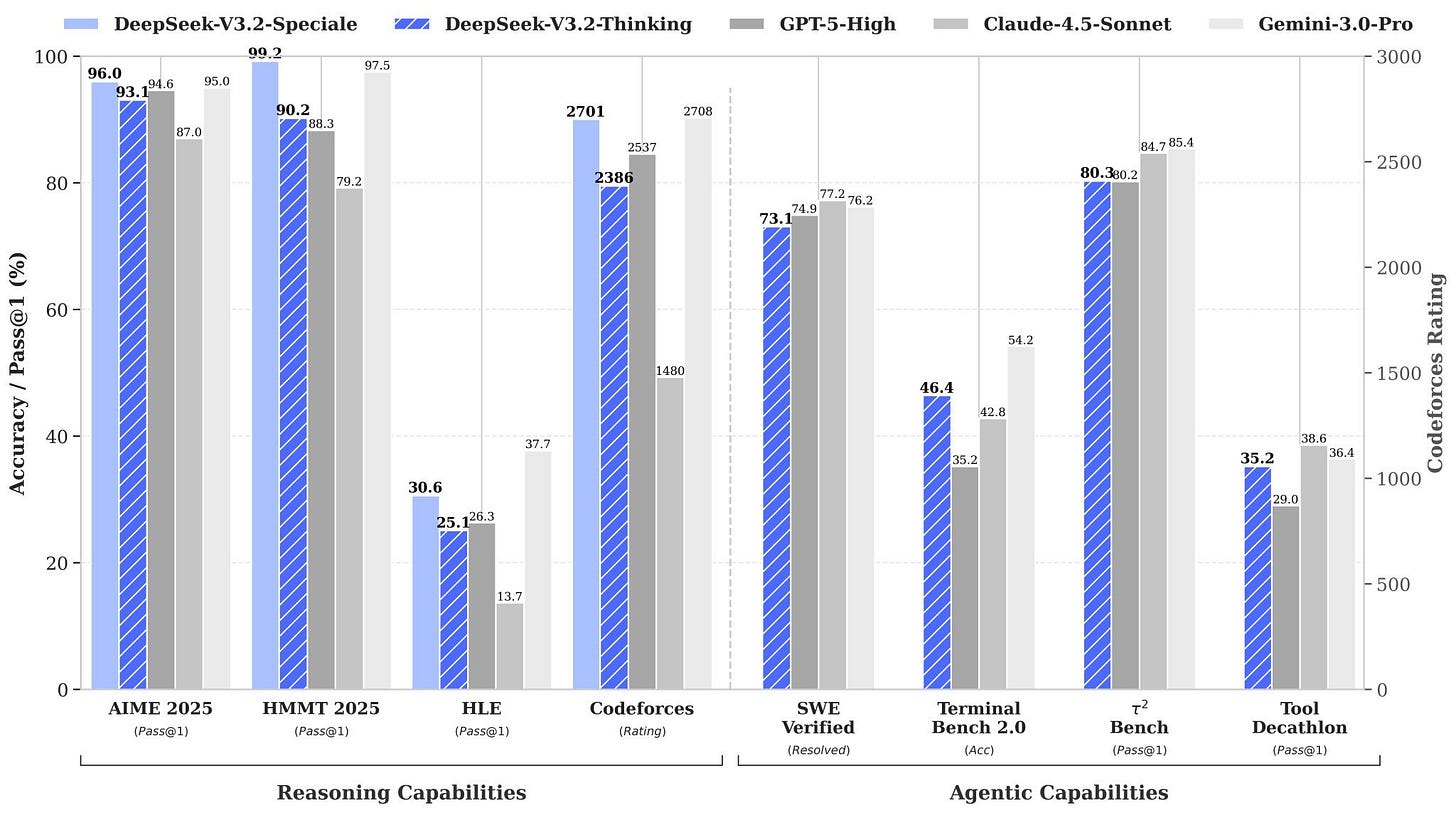

Một là, DeepSeek V3.2 là một cú nhảy của thế giới open source áp sát các hệ thống closed source như GPT hay Gemini, đặc biệt ở mảng suy luận (reasoning).

Hai là, lần đầu tiên, một doanh nghiệp nhỏ ở có thể chạm tay vào một cái “não” rất mạnh, thiên về giải bài toán khó, với chi phí hạ tầng chấp nhận được. Vấn đề không còn là “có model hay không”, mà là “mình có bài toán đủ rõ và quy trình đủ nghiêm để dùng nó hay không”.

2. DeepSeek V3.2 là cái gì, nói sao cho dễ hiểu?

Nghe giới thiệu: model này được tinh chỉnh để thi các kỳ như IMO, CMO, IOI, ICPC, rồi dùng reinforcement learning với ngân sách tính toán sau huấn luyện chiếm hơn 10 phần trăm so với giai đoạn pre training, theo công bố ban đầu.

Nghe vậy hơi choáng, nên ta dịch lại sang đời thường.

Reasoning model: thay vì chỉ giỏi “trò chuyện” cho mượt, nó được luyện để giải những bài toán nhiều bước, phải suy nghĩ, phải kiểm tra lại. Giống học sinh luyện đội tuyển quốc gia, chứ không phải chỉ luyện thi tốt nghiệp.

Agentic model: không chỉ trả lời một phát rồi thôi, mà có thể tự chia nhỏ việc, tự quyết định lúc nào cần tìm kiếm, lúc nào cần chạy code, lúc nào cần dùng công cụ. Cứ hình dung như một nhân viên biết tự đặt câu hỏi, tự tra cứu sổ sách, rồi mới quay lại báo cáo.

RL post training > 10 phần trăm compute: nếu giai đoạn pre training là cho nó đọc cả thư viện, thì giai đoạn RL này là cho nó… luyện đề khó có chọn lọc. Ít đề hơn, nhưng mỗi đề đều được sửa kỹ, góp ý kỹ, sai là bắt làm lại cho đến khi hiểu.

Kết quả là một cái “đầu óc” có xu hướng biết suy nghĩ có trình tự hơn, biết tự kiểm tra lại mình hơn.

3. Ý nghĩa của cú nhảy này

Một là, câu chuyện open source và closed source đổi giọng.

Trước đây nhiều báo cáo nói open weight (không phải open source) chậm hơn closed source khoảng tám tháng. Giờ với các model kiểu DeepSeek, khoảng cách đó đang bị rút ngắn đáng kể. Không phải vì Big Tech đi chậm lại, mà vì bên open đang học cực nhanh, chia sẻ cực nhanh.

Trung Quốc hiện nay áp đảo thế giới (Mỹ) về mô hình open weight và khiến giới chức Mỹ hơi lo ngại. Điều này cũng tạo áp lực rất thật lên các công ty Mỹ: không thể vừa đóng kín vừa thu phí cao, trong khi ngoài kia có lựa chọn đủ tốt, mở, và linh hoạt.

Hai là, cơ hội rất cụ thể cho doanh nghiệp sáng tạo.

Thay vì chỉ mua trọn gói một dịch vụ AI đắt tiền, bạn hoàn toàn có thể:

Dùng model mạnh như DeepSeek V3.2 để dựng trợ lý nội bộ xử lý văn bản, quy trình, tài liệu tiếng Việt.

Xây trợ lý lập trình cho team dev, giảm thời gian gỡ lỗi, đọc code cũ.

Thử nghiệm các “AI agent” nhỏ cho việc tìm kiếm thông tin, chuẩn bị báo cáo, tổng hợp dữ liệu.

Không phải công ty nào cũng cần tự huấn luyện model, nhưng rất nhiều công ty có thể tận dụng model mở để xây hệ thống riêng, cắm vào dữ liệu và quy trình của mình.

Ba là, rủi ro nhận thức nếu chỉ nhìn vào benchmark.

Dễ rơi vào FOMO: thấy chữ “Gold IMO”, “IOI 2025”, “ICPC Finals” là nghĩ ngay “mình mà không dùng là tụt hậu”. Trong khi bài toán quan trọng hơn là:

Doanh nghiệp mình đang thiếu cái gì: quy trình, dữ liệu, hay năng lực suy nghĩ hệ thống của con người?

Dù có cái “đầu” rất mạnh, nhưng thân thể tổ chức không khỏe, có chạy nổi không?

Nếu không cẩn thận, mình chỉ đang đổi logo model trong slide, chứ không thay đổi được chất lượng quyết định trong đời thực.

4. Một chút trải nghiệm: cơn sóng nào cũng giống nhau ở điểm này

Từ thời GPT 3 đến LLaMA, rồi các phiên bản DeepSeek trước, lần nào cũng có hai kiểu câu hỏi gửi cho tôi:

“Anh ơi, giờ công ty nên dùng model nào?”

Rất hiếm người hỏi: “Anh ơi, với bài toán A, dữ liệu B, văn hóa tổ chức C, thì nên thiết kế hệ thống ra sao?”

Thời xưa, người ta hỏi thầy “dạy con chữ gì trước”. Thầy quay lại hỏi “anh muốn con mình thành người như thế nào?”. Câu hỏi gốc chưa rõ, thì bàn công cụ chỉ là nói chuyện dao, kéo, búa.

Với AI cũng vậy. Công cụ có thể rất mới, rất mạnh. Nhưng nếu mình chưa nói được với nhau “mình muốn doanh nghiệp này trở thành kiểu tổ chức nào trong 3 đến 5 năm nữa”, thì thêm một model mới không giải quyết được gốc rễ.

5. Ba việc nhỏ anh chị có thể làm ngay tuần này

Không cần hoảng loạn, cũng không nên bỏ qua. Tôi gợi ý ba việc rất nhỏ:

Một là, gửi cho team kỹ thuật và một vài quản lý chủ chốt hai tài liệu: giới thiệu DeepSeek V3.2 và một bài giải thích đơn giản về reasoning model, agentic model. Yêu cầu mọi người đọc và tóm lại hiểu sao.

Hai là, chọn một bài toán nhỏ, ít rủi ro, cho một nhóm thử nghiệm dựng proof of concept trên nền model mở: ví dụ trợ lý nội bộ trả lời câu hỏi về quy trình hoặc một công cụ hỗ trợ lập trình.

Ba là, ngồi lại với người phụ trách công nghệ và tài chính để so sánh: với bài toán của mình, dùng open source trên hạ tầng riêng, hay dùng dịch vụ closed source bên ngoài, cái nào linh hoạt và an toàn hơn trong 2 đến 3 năm tới.

Chiến lược đi trước, công nghệ đi sau. Đừng đảo ngược thứ tự.

6. Kết luận: DeepSeek là gió, không phải đích đến

Tôi hay nói với anh em: công nghệ là gió, doanh nghiệp là con thuyền, còn chiến lược và văn hóa là tay lái.

DeepSeek V3.2 chỉ là một luồng gió mới, mạnh hơn bình thường. Nó có thể giúp con thuyền của anh chị đi nhanh hơn, nhưng nó cũng có thể làm lật thuyền nếu mình không biết giữ tay lái.

Câu hỏi cho mỗi người trong vai trò lãnh đạo là: mình sẽ dùng cơn gió này để đẩy con thuyền đi xa hơn, hay chỉ dựng thêm vài cánh diều cho vui mắt trên bãi biển mạng xã hội?